L’intelligence artificielle et les techniques de machine learning peuvent aujourd’hui améliorer l’analyse des données dans de nombreux domaines. Y compris dans l’étude des particules fondamentales.

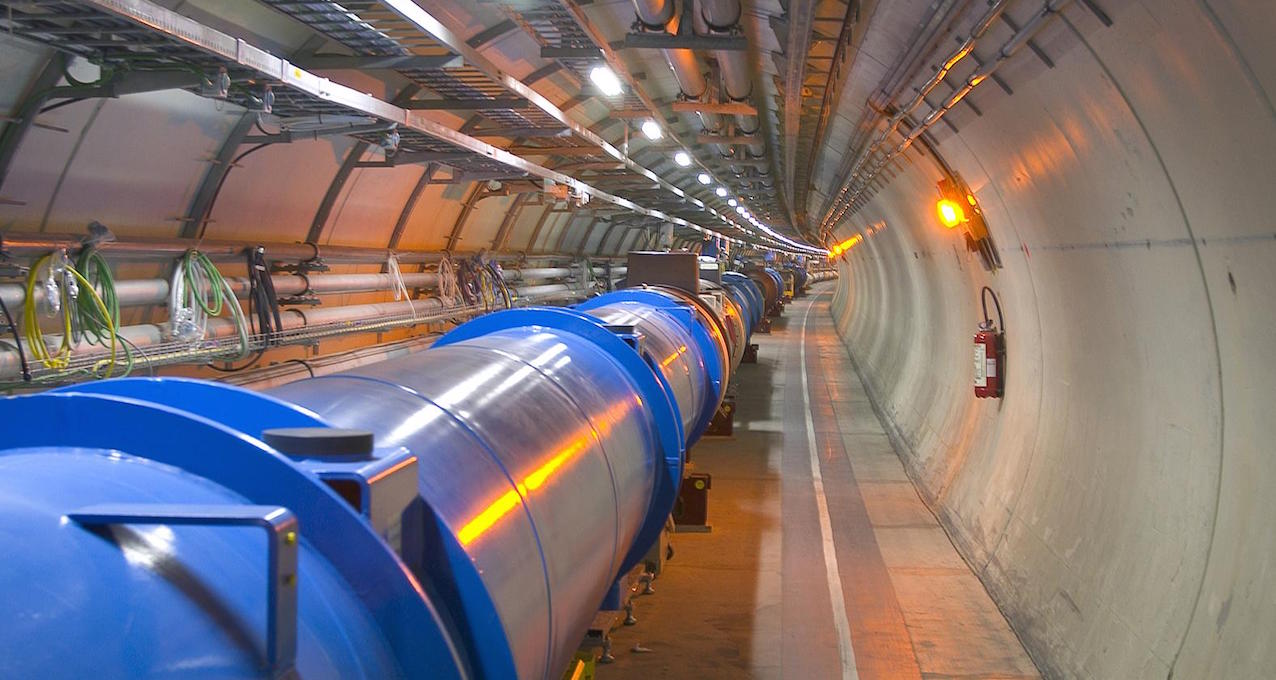

Gilles Louppe, docteur en informatique et professeur à l’ULiège, a travaillé en collaboration avec des chercheurs de l’Université de New York sur ces nouvelles techniques. Dans le but de mieux étudier les données recueillies par les expériences qui jalonnent le grand collisionneur de protons du CERN, le Large Hadron Collider (LHC).

Leurs recherches ont abouti à un modèle mathématique performant. Obtenant une meilleure puissance statistique que les modèles classiques, en deux fois moins de temps.

Accélérer, détecter, étudier

Les laboratoires du CERN sont destinés à découvrir des constituants de la matière et à éprouver les lois de l’Univers.

Pour cela, les scientifiques disposent d’instruments particuliers : des accélérateurs, qui font entrer en collision des particules fondamentales. Et des détecteurs, qui collectent les informations sur ces particules.

Les scientifiques étudient ensuite les résultats en les comparant à leurs hypothèses de départ. Les physiciens restent toutefois confrontés à plusieurs problématiques.

L’IA, douée dans la prédiction des observations

Lorsque les scientifiques veulent prouver qu’une particule existe, ils confrontent deux hypothèses : soit elle n’existe pas, soit elle existe. Ils prédisent alors ce qu’on devrait normalement observer dans un cas ou dans l’autre. Puis confrontent cette simulation à la réalité.

« La difficulté reste la simulation. Si deux hypothèses diffèrent l’une de l’autre, mais de façon subtile, il est alors plus difficile de présager ce qu’on est censé observer » explique le Dr Louppe.

« C’est ici qu’on voit l’intérêt des techniques de machine learning. Car ces méthodes permettent à un logiciel d’apprendre automatiquement la projection précise à faire des données collectées » poursuit-il.

Des milliers d’informations par seconde

Une autre contrainte pour les physiciens du CERN est le nombre de données pour l’analyse statistique.

« Au moment de la collision, on observe une cascade de désintégration, et nous avons en réalité des milliers de résidus de la particule (électrons, muons, etc.), rappelle le Pr Louppe. Ceux-ci traversent les matériaux du détecteur en déposant une certaine quantité d’énergie, qu’on lira de façon électronique ».

Tels des appareils photo, les détecteurs capturent ainsi des milliers d’images par seconde. À ce jour, le CERN a dépassé l’étape des 200 petabytes (Pb) de données archivées: 1 PB correspondant à 13 années de vidéos HD…

Le modèle mathématique du Dr Louppe pourrait pallier cette difficulté. En l’appliquant dans leurs calculs, les physiciens n’auraient en effet plus besoin de produire autant de données.

« Au lieu de calculer des statistiques sur 3 années de données, et dépenser de l’énergie à faire fonctionner de LHC durant cette période, un an et demi suffirait pour obtenir le même résultat ! ».

Prédire le futur… scientifiquement

En résumé, « notre modèle est beaucoup plus efficace au niveau de la récolte des données, car il sait automatiquement identifier la description optimale des données, afin de rejeter l’une ou l’autre hypothèse. Et donc avoir une puissance statistique supérieure », indique l’informaticien.

La méthode n’a pour le moment été testée qu’avec des données simulées. Les chercheurs espèrent cependant l’expérimenter rapidement, y compris dans d’autres champs scientifiques.

« Le modèle ne s’applique pas seulement aux projets du CERN. Il pourrait en réalité s’employer à tous les domaines scientifiques œuvrant sur la simulation de données. Incluant les domaines de la cosmologie, de l’épidémiologie, de la géologique, ou de la climatologie » énumère le scientifique.

Aussi, les conséquences d’une épidémie, d’un tremblement de terre ou même du réchauffement climatique seraient de plus en plus prévisibles à l’avenir.